发布时间:2012-09-21 阅读量:1444 来源: 发布人:

据最新消息,苹果公司计划于2027年推出其首款机器人产品,这款代号为"Eve"的虚拟伴侣机器人,将结合苹果在硬件设计、人工智能和用户体验方面的优势,开创消费级机器人新品类。不同于传统功能性机器人,苹果的这款产品更注重情感连接和个性化陪伴,有望重新定义人机交互的未来。

在当前全球电子制造业向智能化、绿色化加速转型的背景下,产业链协同创新已成为突破技术壁垒的关键路径。本次走访聚焦微焦点X-RAY检测、自动化测试烧录一体化、半导体封装工艺等核心技术领域,通过构建"技术攻关-场景验证-生态协同"的三维合作模型,旨在打通从实验创新到规模化应用的最后一公里。

美国为防止高端人工智能(AI)芯片通过第三方渠道流入中国,已秘密要求芯片制造商英伟达(NVIDIA)、超威半导体(AMD)等企业在出口至部分国家的AI芯片中植入追踪程序,以便实时监控芯片流向

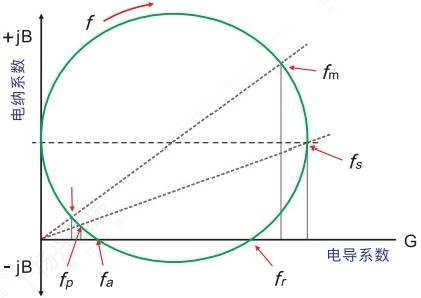

在电子电路设计中,晶振的每一项参数都与产品命运息息相关——哪怕只差0.1ppm,也可能让整板“翻车”。看似最基础的术语,正是硬件工程师每天必须跨越的隐形门槛。

在电子电路设计中,晶振的每一项参数都与产品命运息息相关——哪怕只差0.1ppm,也可能让整板“翻车”。看似最基础的术语,正是硬件工程师每天必须跨越的隐形门槛。